만일 섀도 IT가 SaaS 시대의 길티 플레저라면, 섀도 AIT는 승인, 로깅 또는 제어 없이 비즈니스 워크플로에 은밀히 연결되는 승인되지 않은 AI 모델, 도구 및 자율 에이전트인 GenAI에게 슈거 러시과 같은 존재입니다. 빠르고, 유용하지만 공격적입니다.

Netskope의 2025 GenAI 보고서에 따르면 현재 기업은 평균 약 6개의 GenAI 앱을 사용하고 있으며, 상위 25% 기업은 13개 이상의 앱을 사용하고 있으며, 전체적으로 300개 이상의 서로 다른 GenAI 앱을 추적하고 있습니다. 또한 GenAI 앱으로 전송되는 데이터가 전년 대비 30배 증가한 것으로 나타났습니다. Menlo Security의 AI 보고서에 따르면 섀도 GenAI가 68% 급증하여 ‘유용한’ 기능이 ‘위험한’ 기능으로 바뀌고 있다고 경고합니다. Cisco의 2025 준비도 지수에 따르면 조직의 약 60%가 승인되지 않은 AI 도구를 식별하는 데 확신이 부족한 것으로 나타났으며, 이에 따라 모니터링의 필요성이 강조되고 있습니다. Gartner는 이 문제를 GenAI 데이터 프로그램 오류와 연관시킵니다.

섀도 AI는 조직과 직무 전반에 걸쳐 확산되고 있으며, 데이터 노출 및 거버넌스 위험이 실제로 발생하고 있습니다. 특히 직원이 자신의 AI를 가져올 경우 더욱 그러합니다.

이 문서는 섀도 AIT를 발견하고 관리하기 위한 실용적인 원격 측정 중심 가이드입니다. 탐지를 MITRE ATLAS, LLM 앱용 OWASP Top 10, NIST AI RMF에 매핑하고 수집해야 할 로그(CloudTrail, CloudWatch, 엔드포인트, 앱 로그, 모델 컨텍스트 프로토콜/MCP 원격 측정)에 대해 구체적으로 알아볼 것입니다. 지금 바로 SIEM에 설치할 수 있는 Sumo Logic 스타일 쿼리도 보여드리겠습니다.

Respond faster with Sumo Logic Dojo AI

Cut through the noise, detect threats faster, and resolve issues before they disrupt your operations.

섀도 AIT 소개

섀도우 AIT는 프로덕션 데이터와 시스템에 영향을 미칠 수 있는 AI 서비스, AI 도구, 에이전트 글루(플러그인/도구, MCP 서버, Bedrock Agents, LangChain 도구 등)를 보안의 가시 범위를 벗어나 무단으로 사용하는 모든 것을 말합니다.

AI 열차는 이미 역을 떠났습니다. 기업이 처한 난제는 AI 도구를 허용하지 않으면 오히려 섀도 AI를 장려하게 된다는 점입니다. 직원들은 이미 AI가 삶의 모든 측면에 가져다주는 가치를 체감했으며, AI 사용을 막아도 숨어서 사용하게 될 뿐입니다. AI는 단순히 데이터를 처리하는 데 그치지 않고 데이터를 통해 학습하고, 엉뚱한 결과를 만들어내고, 가장 민감한 시스템에 액세스하고, 때로는 가족 모임에서 술 취한 삼촌처럼 비밀을 흘리기도 한다는 점에서 섀도 IT와 비슷하지만, 그보다 훨씬 더 강력합니다.

왜 섀도 AI가 급증할까요? AI 도구의 보편화 때문입니다. 이제 비기술자도 에이전트를 실행하여 작업을 자동화하거나 copilot으로 전문가처럼 코딩할 수 있을 만큼 도구의 접근성이 높아졌습니다. 그러나 관리 감독이 부재하면 데이터 유출부터 규정 준수 위반 문제까지, 기업 전반에 위험 사각지대가 생깁니다.

머지않아 사고 발생 후 진행되는 회의에서 리더들이 “그 애플리케이션이 AI를 사용하는지 몰랐다”고 말하거나, AI를 그런 식으로 사용하도록 승인한 사람이 누구인지 물을 수 있습니다. 섀도 IT를 방지하려면 팀의 AI 전략에 힘을 실어주고 혁신을 지원하되, 너무 많은 마찰을 일으키지 않는 범위에서 통제와 거버넌스를 구현해야 합니다.

AI 레드팀 역할을 하거나 침투 테스트 평가를 수행할 수 있을 만큼 경험이 충분하면 보너스 점수를 받을 수 있습니다. 이러한 평가자와 협력하여 테스트 중에 로그 원격 측정을 캡처하면, 향후 악의적인 행동이나 AI 남용을 포착할 수 있는 탐지 규칙을 만들 수 있습니다.

프로그램의 기반이 되는 프레임워크

AI TRiSM

AI TRiSM은 인공 지능 신뢰, 위험 및 보안 관리의 약자입니다. Gartner에서 만든 이 프레임워크는 AI 시스템의 전체 수명 주기 동안 신뢰성, 규정 준수, 보안을 보장하도록 설계되었습니다. 쉽게 말해, 신뢰는 AI가 어떻게 결정을 내리는지 설명할 수 있는지, 공정하고 신뢰할 수 있으며 편견이 없는지에 대해 묻습니다. 위험은 어떤 문제가 발생할 수 있는지를 다루며, 데이터 유출, 거짓 정보, 적대적인 해킹, 규제 문제 등을 예로 들 수 있습니다. 보안은 모델, 데이터, 인프라를 공격·오용·무단 액세스로부터 어떻게 보호할지를 다룹니다.

NIST AI RMF 1.0 + 생성형 AI 프로파일(AI 600-1)

NIST의 AI 위험 관리 프레임워크는 맵(위험 식별), 측정(정량화), 관리(완화), 거버넌스(전체 감독)와 같은 핵심 기능을 갖춘 거버넌스 GPS입니다. 사용자 환경에서 승인되지 않은 AI 사용을 매핑한 다음 AI 시스템에 대한 사고 대응 요구 사항을 준수하면서 데이터 노출률과 같은 메트릭을 통해 위험을 측정하여 섀도 AI에 적용하세요.

MITRE ATLAS

MITRE ATLAS는 MITRE ATT&CK와 같은 AI 시스템용 공격자 플레이북이지만, 머신 러닝 위협에 맞게 조정되었습니다. 데이터 포이즈닝(악의적인 행위자가 학습 데이터를 조작하는 것) 또는 모델 회피(AI가 잘못된 결정을 내리도록 속이는 것)와 같은 전술을 매핑합니다. ATLAS를 활용해 로그를 매트릭스와 교차 검증하여 섀도 AI 위험을 평가하세요. 예를 들어, 악성 코파일럿에서 회피 기술을 암시하는 비정상적인 API 호출을 발견할 수 있습니다.

OWASP 선정 LLM 앱의 10가지 위험(2025년 업데이트)

이 자료는 프롬프트 주입(모델을 탈취하는 교묘한 입력)이나 민감 정보 유출(출력에서 개인 식별 정보(PII) 유출)과 같이 대규모 언어 모델(LLM)에 특화된 취약점을 소개합니다. 섀도 AI 상황에서는 직원들이 자신도 모르게 이러한 문제를 일으킬 수 있습니다. 예를 들어, 마케팅 팀은 승인되지 않은 LLM 앱을 사용하다가 과도하게 의존(거짓 정보가 가득한 결과물을 맹목적으로 신뢰)하여 잘못된 비즈니스 결정을 내릴 수 있습니다.

기록할 내용(및 기록해야 할 이유)

클라우드/모델 API

먼저 AWS Bedrock(섀도 AI 실험의 중심지)과 같은 서비스의 API 로그에 연결하세요. 예를 들어, converse 및 converse_stream 호출을 모니터링합니다. 입력/출력 토큰, 지연 시간, 분당 호출 수와 같은 메트릭을 추적하세요.

대부분의 클라우드 제공업체는 텔레메트리를 문서화했습니다. 예를 들어 AWS Bedrock에서는 다음과 같은 계측을 제공합니다.

- InvokeModel / Converse / ConverseStream 및 Agents(InvokeAgent)에 대한 CloudTrail 관리/데이터 이벤트. ID, 모델 ID 및 지역 간 이상 징후 탐지에 유용합니다.

- CloudWatchAgents 메트릭: 호출, 토큰 수, 첫 번째 토큰까지의 시간(TTFT), 스로틀, 클라이언트/서버 오류 – 가드레일 차단률 및 비용/오남용 이상값 감지에 적합합니다.

- CloudWatch Logs/S33에 대한 호출 로깅(입력/출력) – 포렌식 및 레드팀 프롬프트(신중한 PII 거버넌스 사용)에 중요합니다.

Sumo Logic에서 CloudTrail + CloudWatch + invocation log를 대시보드 및 쿼리에 바로 연결할 수 있는 Bedrock 앱을 제공합니다.

모델에 관계없이 GenAI 사용량을 모니터링하기 위해 무거운 전용 스택이 필요하지 않습니다. OpenAI 스타일의 API는 이미 사용자가 관심 있는 원격 분석 데이터(지연 시간, 오류, 토큰 수, 중재 결과)를 반환합니다. 개발자가 자체 AI 기능을 개발하는 경우 SDK 호출을 계측하세요. 예를 들어, SDK 호출을 작은 Python ‘에이전트’로 래핑하고 구조화된 이벤트를 방출한 다음 사용하는 SIEM/관측 플랫폼으로 전달하세요. 원격 분석에는 일반적으로 통화율, 오류율, 입력 및 출력 토큰 수, 선택 사항으로 샘플링된 프롬프트/응답이 포함됩니다. HTTPS 수집기를 통해 JSON 이벤트를 SIEM으로 전송하세요(추적/스팬 컨텍스트가 필요한 경우 OpenTelemetry의 새로운 GenAI 시맨틱 규칙을 통해 이러한 필드를 표준화할 수 있지만 선택 사항입니다).

권한이 없는 에이전트 감지

에이전트(자율 AI 작업자)는 API와 채팅하는 것을 좋아합니다. 로그 패턴을 사용하여 예기치 않은 API 키나 지리적 위치와 같은 비정상적인 동작에 플래그를 지정하세요. ‘ML 공급망 침해’와 같은 전술(예: 수상한 모델 허브에서 다운로드를 보여주는 로그)에 대해 경고하여 이를 MITRE ATLAS와 연결하세요. 엔드포인트/CLI/프록시에서 셸 기록을 캡처하고 DNS/HTTP를 이그레스하여 퍼블릭 LLM 또는 에이전트 백엔드에 대한 승인되지 않은 호출(예: api.openai.com, api.anthropic.com, *.hf.space, *.perplexity.ai, *.deepseek.com)을 감지합니다.

MCP(모델 컨텍스트 프로토콜) 감사

MCP는 LLM 앱이 JSON-RPC를 통해 도구, 리소스, 프롬프트를 연결하는 방식을 표준화합니다. 로그 도구/목록, 도구/호출, 리소스/읽기, 프롬프트/겟, 사용자 승인 및 클라이언트/서버 전반의 상관관계 ID와 같은 정보가 감사에 유용합니다. 최신 사양에서는 로깅, 기능 협상 및 보안 고려 사항을 명시적으로 언급하고 있으므로 이를 활용하세요.

원격 분석 속 섀도 AIT: 세 가지 실제 패턴

여기서 중요한 건 섀도 AIT와 내부자 위협 사이의 경계가 매우 빠르게 모호해질 수 있다는 점입니다. 직원들이 AI로 혁신을 이루면서도 잠재적인 보안 위험을 인식하지 못하거나, AI를 악용하는 악의적인 공격자의 희생양이 되는 경우가 있습니다. 이러한 패턴과 탐지는 패턴의 의도와 관계없이 팀에 도움이 될 수 있습니다.

패턴 1 – Prompt-to-Tool Pivot(OWASP LLM07/LLM08, ATLAS: 프롬프트 주입)

정상적으로 보이는 프롬프트로 에이전트는 고위험 도구(예: 시크릿 읽기, 작업 실행)를 호출합니다. 일반 채팅 요청이 표시되고 바로 뒤에 민감한 도구/호출 또는 Bedrock Agent 작업이 표시됩니다.

로그 및 경고 대상

- 비즈니스 컨텍스트 또는 사용자 승인 플래그와 일치하지 않는 MCP

도구/호출을 민감한 도구(시크릿, prod API)로 호출 - BedrockInvokeAgent 급증 또는 “최초 탐지” 신원(UEBA)에 의한 새 작업 그룹 생성

패턴 2 – 토큰 플러드를 통한 Cost/DoS(OWASP LLM04, ATLAS: 리소스 고갈)

변조된 프롬프트 또는 루프로 인해 토큰이 무한정 증가하거나 재시도가 반복됩니다.

로그 및 경고 대상

- CloudWatch InputTokenCount/OutputTokenCount는 ID/모델별로 출력되며 InvocationThrottles가 증가합니다.

- 컨텍스트 창이 확장되는 것을 보여주는 호출 로깅(갑자기 입력 크기가 4배 증가).

패턴 3 – 승인되지 않은 GenAI 사용(섀도 AIT “클래식”)

엔드포인트가 기업 네트워크에서 소비자 AI API와 통신한 다음 결과를 기업 시스템에 복사/붙여넣기합니다.

로그 및 경고 대상

- 권한 목록에 없는 ID로 알려진 LLM 도메인에 대한 이그레스/DNS, 키보드 매크로/복사 버퍼가 헬프데스크 조사에 나타납니다. 업계 설문조사에 따르면 팀에서 실행 중인 AI 서비스에 대한 가시성이 부족한 경우가 많은데, 로그를 통해 이러한 문제를 해결할 수 있습니다.

적용 가능한 Sumo Logic 스타일 탐지

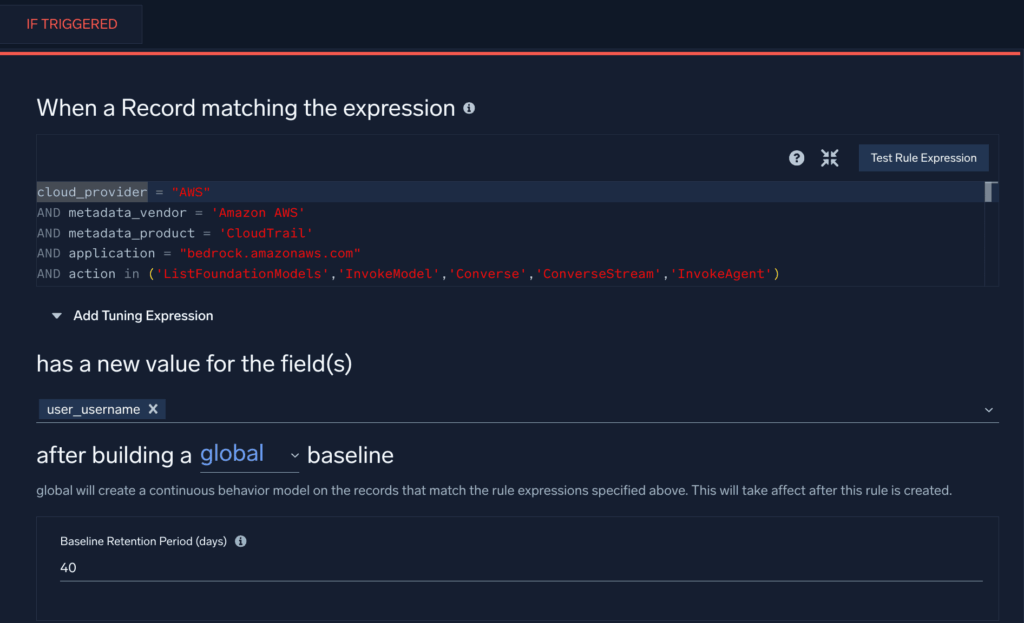

새로운 ID의 Bedrock API 사용(정찰/열거) → ATLAS TA0002; OWASP LLM10

이 Cloud SIEM최초 탐지 규칙은 Bedrock 방어자 지침에서 수정되었으며 AWS 환경에서 특정 Bedrock API 호출을 사용하는 새로운 사용자가 관찰될 때 트리거됩니다.

고정 키(계정 오용)의 교차 지역 InvokeModel → ATLAS 초기 액세스, OWASP LLM10

이 검색 쿼리는 둘 이상의 지역에서 Bedrock 리소스를 인스턴스화하기 위해 액세스 키를 재사용할 수 있는 가능성을 식별합니다.

_sourceCategory=aws/observability/cloudtrail/logs

| json "eventName","userIdentity.accessKeyId","awsRegion","userIdentity.type" as en, key, region, utype

| where en="InvokeModel" and utype in ("IAMUser","AssumedRole")

| timeslice 1h

| count as c by key, region, _timeslice

| count_distinct(region) as regions by key, _timeslice

| where regions > 2

Guardrail/Trace anomalies on Bedrock Agents (OWASP LLM06, LLM04)

다음 쿼리는 Bedrock 에이전트의 비정상적인 오류 또는 스로틀링 활동 비율을 확인하여 에이전트의 오용 가능성을 나타냅니다.

_sourceCategory=aws/observability/cloudwatch/metrics

(metric=ModelInvocationClientErrors or metric=ModelInvocationServerErrors or metric=InvocationThrottles)

| quantize to 5m

| sum by metric, agentAliasArn, modelId, account, region

| outlier window=1d threshold=3 // flag unusual error/throttle bursts

섀도 AIT 이그레스(승인되지 않은 LLM 엔드포인트)

다음 쿼리는 프록시 및 방화벽 로그에서 승인되지 않은 LLM 엔드포인트에 대한 연결이 있는지 검색합니다. 원하는 경우 이러한 엔드포인트에 연결할 수 있는 사용자의 조회 테이블을 만들고 조회 테이블 경로를 추가합니다.

(_sourceCategory=proxy OR _sourceCategory=fw)

| parse regex field=url "(?i)https?://(?<host>[^/]+)"

| where host in ("api.openai.com","api.anthropic.com","*.hf.space","*.perplexity.ai","*.deepseek.com")

| lookup user as u1 from path://{path_to_lookup_table} on user=user

| where isNull(u1)

| count by user, host, src_ip

MCP 감사: 승인 없는 고위험 도구 호출(OWASP LLM07/LLM08)

아래와 같이 앱 로그를 내보낸다고 가정합니다.

{

"ts":"2025-08-20T15:01:12Z",

"event":"mcp.tools.call",

"session_id":"s-9a2f",

"client_id":"webapp-01",

"server_uri":"secrets://v1",

"tool":"secrets.read",

"inputs":{"path":"prod/db/password"},

"approved":"false",

"user":"dba_alice"

}

쿼리:

_sourceCategory=app/mcp

| json "event","tool","approved","user","server_uri" as evt,tool,ok,u,server nodrop

| where evt="mcp.tools.call" and tool matches /(secrets|prod|delete|exec)/ and ok="false"

| count by u, tool, server

(MCP의 JSON-RPC 사양 및 서버 개념 지원, 도구 도구/목록/호출, 리소스/읽기, 프롬프트/겟, 및 사용자 승인)

ChatGPT 모니터링 사례 연구

Sumo Logic의 강점 중 하나는 다재다능함입니다. 턴키 앱과 탐지 기능을 제공하지만, 진정한 가치는 고객이 플랫폼을 확장하는 방식에서 비롯됩니다. 예를 들어, 최근 고객이 로그 수집부터 실행 가능한 인사이트에 이르기까지 OpenAI의 ChatGPT 사용을 엔드투엔드 모니터링하는 데 도움을 준 프로젝트에 대해 전문 서비스 엔지니어인 Bill Milligan에게 공유해 달라고 요청했습니다.

고객의 문제: Sumo Logic이 ChatGPT 프롬프트 교환을 추적하여 대화 맥락을 기반으로 잠재적인 내부 위협이나 직장 폭력으로 이어질 수 있는 정신 건강 문제의 초기 징후를 식별할 수 있을까요?

1단계 – 데이터 수집

OpenAI 기업 고객은 ChatGPT 컴플라이언스 API를 사용하여 사용자 입력, 시스템 메시지, 출력, 업로드된 파일 및 GPT 구성 데이터를 포함한 자세한 로그 및 메타데이터에 액세스할 수 있습니다. 하지만 현재 이 피드에 대한 클라우드 간 커넥터나 카탈로그 앱은 아직 사전 구축되어 있지 않습니다.

Bill은 API 엔드포인트가 있는 모든 데이터 소스를 수집할 수 있는 Sumo Logic의 Universal API Collector를 사용하여 이 문제를 해결했습니다. 또한 수집기는 JPath를 지원하므로 특정 JSON 필드(예: $.user.id, $.message.text)를 추출하여 Sumo의 검색 가능한 필드에 직접 매핑할 수 있습니다.

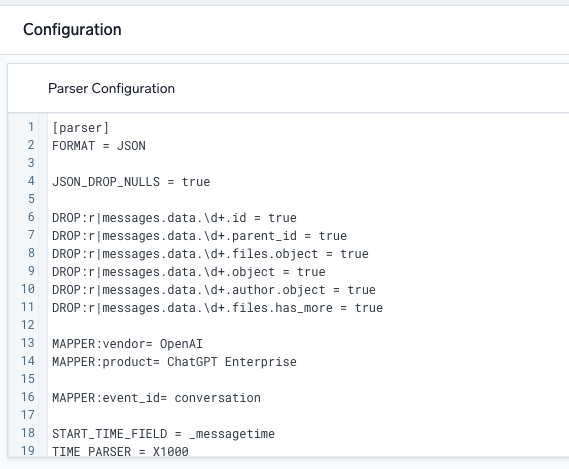

2단계 – 간단한 파싱 빌드

OpenAI API에서 데이터가 성공적으로 유입되자 Bill은 Sumo Logic의 강력한 기본 파싱 언어를 사용했습니다. 이를 통해 고객은 타임스탬프를 식별하고, 제품 및 공급업체와 같은 메타데이터 값을 할당하고, 메시지를 다양한 방식으로 슬라이스 및 변환할 수 있습니다. 다행히도 파서는 기록 데이터를 사용하여 UI에서 직접 개발 및 테스트할 수 있으므로 반복을 빠르고 눈에 띄게 수행할 수 있습니다.

“Parser”는 원시 로그가 Cloud SIEM으로 전달될 때 이를 구문 분석하여 공급업체, 제품 및 이벤트 ID와 함께 관심 있는 필드를 추출합니다.

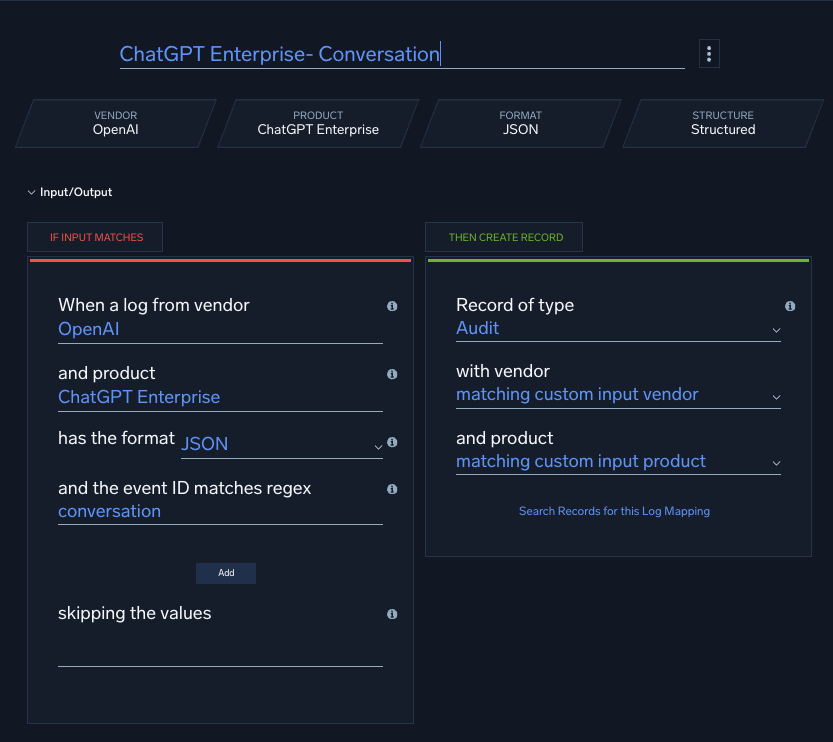

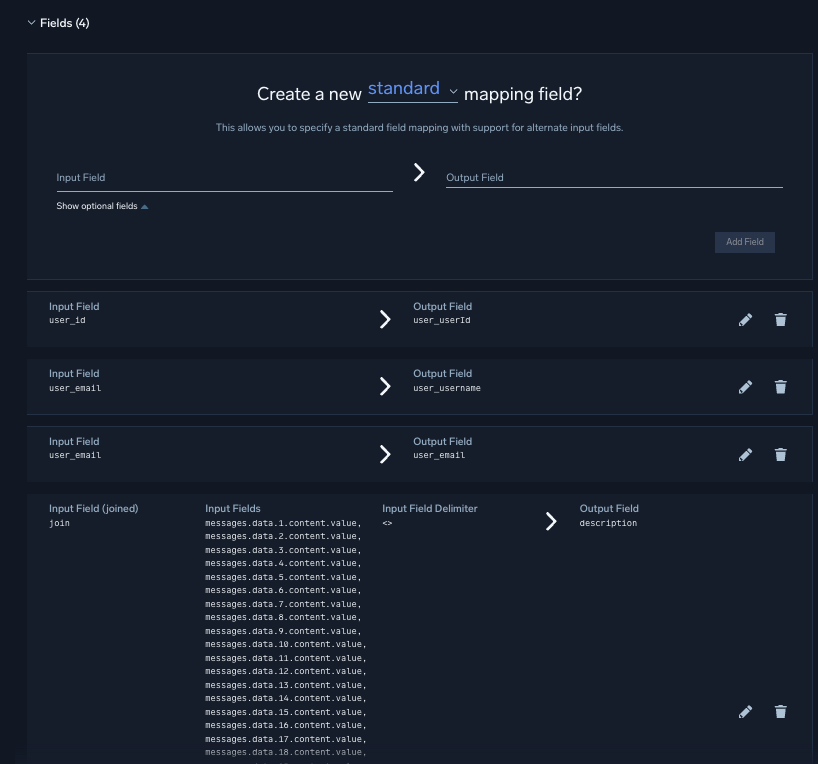

3단계 – 스키마 또는 데이터 모델에 매핑

Sumo Logic에서 구문 분석과 매핑은 별개의 단계입니다. 파싱 후 Bill은 사용자 지정 매퍼를 만들어 필드를 Sumo의 데이터 모델에 맞췄습니다. 또한 여러 개의 프롬프트/응답 쌍을 하나의 대화 필드(설명)로 연결하여 키워드를 더 쉽게 검색할 수 있도록 했습니다.

전문가 팁: 기본적으로 Sumo Logic 테넌트는 로그 메시지를 64KB로 제한합니다. 이러한 대화는 상당히 커질 수 있기 때문에 256KB로 제한을 늘려달라고 요청하여 불필요한 로그 잘림을 피할 수 있었습니다.

“로그 매퍼”가 공급업체, 제품 및 이벤트 ID와 일치하면 규칙 엔진에서 분석하기 전에 파서에서 추출된 필드를 정규화된 레코드에 매핑합니다.

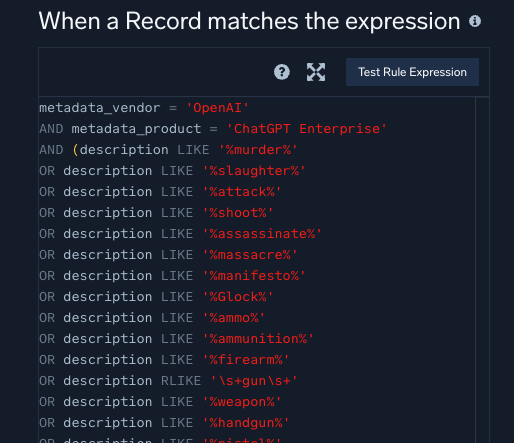

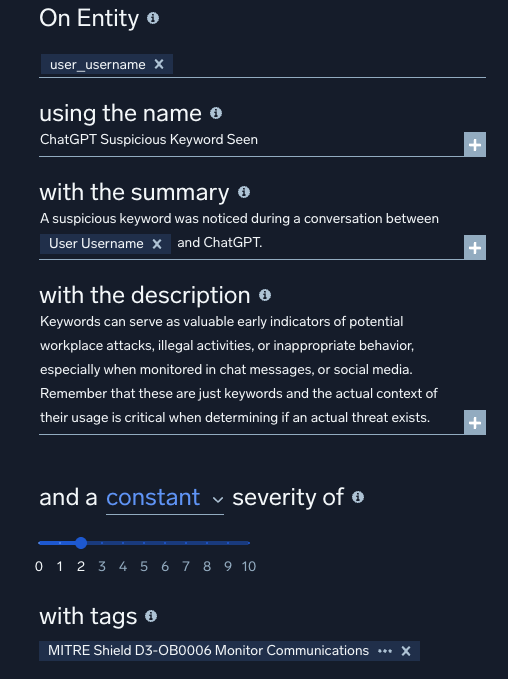

4단계 – 사용자 지정 규칙 작성

마지막으로 Bill은 민감한 키워드를 모니터링하기 위해 사용자 지정 검색 규칙을 구현했습니다. 규칙은 노이즈를 줄이기 위해 엔티티(사용자)로 범위를 지정하고 컨텍스트에 맞게 MITRE 태그를 사용하여 조정합니다. 모범 사례에 따라 규칙은 먼저 프로토타입 모드에서 배포한 후 라이브에 적용합니다. 이렇게 하면 보안 분석가가 모니터링하는 경보 분류를 망치지 않고 모든 엔티티(이 경우 사용자)에 대해 규칙을 실행할 수 있습니다.

이것은 Cloud SIEM에서 작성할 수 있는 6가지 강력한 규칙 유형 중 하나인 “일치” 규칙에 대한 규칙 표현의 예시입니다.

Bill은 사용자 지정 규칙에 MITRE 태그를 추가하여 규칙이 실행될 때 결과 신호에 의미 있는 컨텍스트가 포함되도록 했습니다. Sumo Logic은 신호와 행동을 개별 엔티티에 자동으로 연결하기 때문에 이 규칙은 다른 규칙과 결합하여 사용자의 활동을 충실도가 높고 실행 가능한 알림으로 격상할 수 있습니다.

워크플로가 복잡해 보일 수 있지만, 명확한 단계로 나누면 사용자 지정 로그 소스를 수집하고 가장 고급 사용 사례도 매우 간단하게 처리할 수 있습니다.

결론

현재 일반적인 조직은 놀라울 정도로 많은 수의 세대별 AI 앱을 실행하고 있으며, 그 중 상당수는 승인되지 않은 상태입니다. 이러한 현상은 줄어들지 않고 오히려 더 늘어날 것으로 예상됩니다. 섀도 IT와 사촌 섀도 AI: 팀이 IT 부서에 알리지 않고 검증되지 않은 도구(또는 무료 AI 채팅)를 배포하여 수많은 유출과 편견의 위험을 안고 있으며 이로 인해 누출과 편견이 만연할 위험이 있습니다.

해결책은 뭘까요? 로그가 모든 것을 말해줍니다. Sumo Logic 대시보드에서 네트워크 흐름과 앱 사용량을 모니터링하여 잠재적 위험을 조기에 발견하세요. 지시하지 말고 교육하세요. AI 샌드박스를 관리하여 적을 아군으로 전환하세요. 나아갈 방향이 필요하신가요? 클라우드 프록시/CASB 로그를 사용하여 AI 사용량을 열거하고, AI TRiSM 스타일의 거버넌스를 적용하고, 위험한 조합(예: 민감한 데이터 클래스 → 승인되지 않은 AI 도메인, 에이전트 도구 호출의 갑작스러운 급증)에 대한 SIEM 탐지를 생성하세요. 이는 모든 AI를 차단하는 것이 아니라 알려지지 않은 것을 관찰 가능하고 관리 가능한 것으로 대체하는 것입니다.