Mit ca. 1,145 Billionen MB an Daten, die täglich generiert werden, rückt Big Data immer mehr in den Mittelpunkt der Geschäftswelt. Die erfolgreiche Analyse der Informationen aus diesen riesigen Datensätzen kann nahezu alle Bereiche eines Unternehmens beeinflussen. Hinzu kommt, dass die moderne Arbeitswelt zunehmend digitalisiert ist, was bedeutet, dass technische Teams heute für jedes Unternehmen unerlässlich sind.

Da immer mehr Unternehmen Hyper-Scale-Cloud-Provider und Microservices für moderne Anwendungen einsetzen, werden immer mehr maschinelle Daten produziert, was zu einer enormen Datenflut beiträgt. Doch neben den bemerkenswerten Vorteilen von Big Data gibt es auch eine ganze Reihe von Herausforderungen.

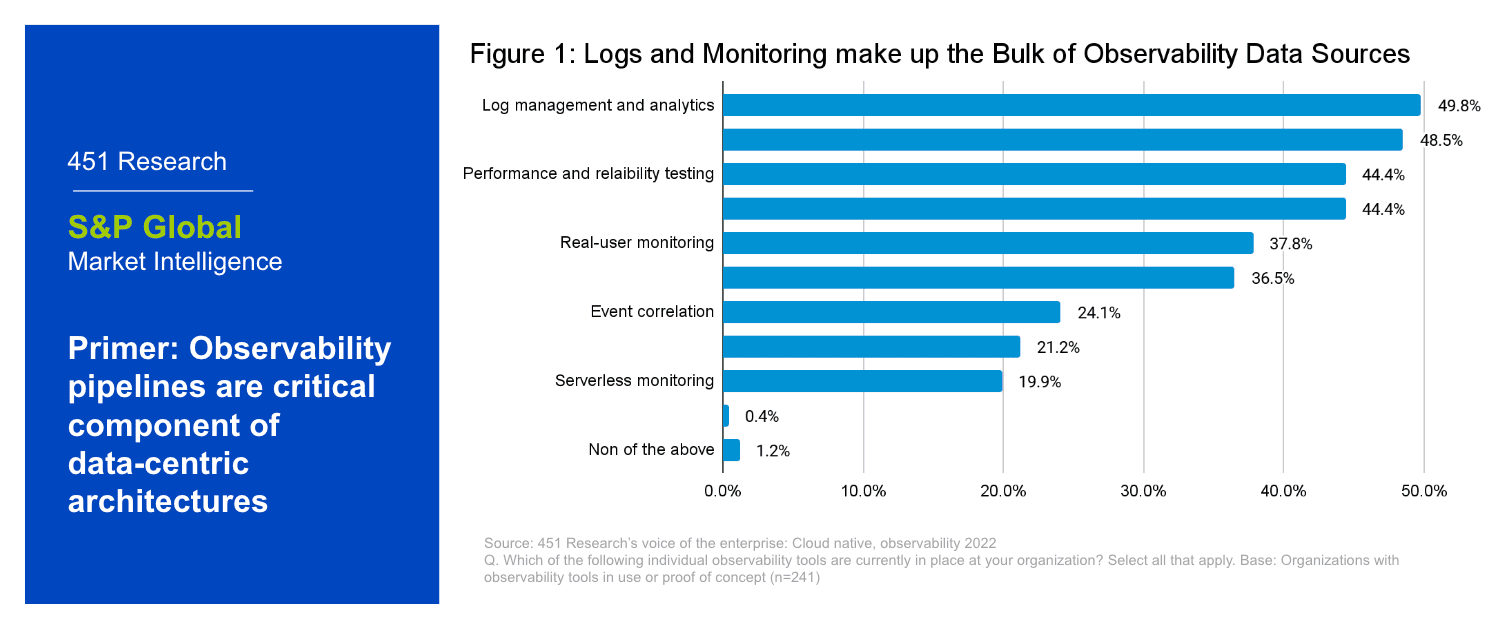

Zur Veranschaulichung betrachten wir Logdaten: Sie bilden den umfangreichsten Datensatz für Monitoring, Planung, Sicherheit und Optimierung. Während viele Unternehmen das Potenzial von Logdaten in der Vergangenheit ignoriert haben, gelten sie heute als die unerschlossene Goldgrube unter den Monitoring-Daten.

Doch aufgrund ihres immensen Umfangs und ihrer Komplexität ist das Sortieren der unstrukturierten, von Maschinen stammenden Logdaten ein gewaltiges Unterfangen. Mit einem robusten Log-Management-Prozess können Sie diese großen und schnellen Datenmengen problemlos organisieren und analysieren.

Was ist der Prozess des Log-Managements?

Auf einer hohen Ebene befasst sich das Log-Management mit allen Aspekten von Protokollen und verfolgt dabei zwei Ziele:

- Sammeln, Speichern, Verarbeiten, Synthetisieren und Analysieren von Daten, um die digitale Leistung und Zuverlässigkeit zu verbessern, Fehler zu beheben, forensische Untersuchungen durchzuführen und Geschäftserkenntnisse zu erlangen.

- Gewährleistung der Zuverlässigkeit, Konformität und Sicherheit von Anwendungen und Infrastrukturen über den gesamten Software-Stack eines Unternehmens hinweg.

Drei Hauptkomponenten machen einen umfassenden Log-Management-Prozess aus: Verfahren, Richtlinien und Tools. Um einen besseren Einblick in diese Konzepte zu erhalten, hat Sumo Logic diesen Leitfaden erstellt, der diese Komponenten im Detail erläutert.

Warum ist die Log-Management wichtig?

Im Kern geht es beim Log-Management um das Sammeln, Organisieren und Korrelieren enormer Mengen von Protokollereignissen, um Analysen und Erkenntnisse in Echtzeit zu gewinnen. Dies ist aus mehreren Gründen entscheidend, unter anderem für:

- Höhere Sicherheit: Log-Management erfasst lückenlos alle Benutzeraktivitäten. Dies hilft dabei, Datenkompromittierungen, Sicherheitsverletzungen und andere Risiken zu verhindern, deren Ursachen zu identifizieren und die Auswirkungen zu minimieren.

- Verbesserte Systemzuverlässigkeit: Das Monitoring von Logdateien sorgt dafür, dass DevOps-Teams besser informiert sind, da sie die Systemfunktionen mühelos überwachen können. Zudem hilft Log-Management den Teams dabei, die Ursachen von Performance-Problemen im Ernstfall schnell zu identifizieren.

- Bessere Kundeneinblicke: Die aus Protokollen und Log-Analysen gewonnenen Erkenntnisse gehen weit über die Verbesserung von Sicherheit und Systemleistung hinaus. Diese Daten helfen Unternehmen auch dabei, besser zu verstehen, wie Kunden mit ihren Anwendungen interagieren. Dazu gehört die Analyse der verwendeten Browser ebenso wie weitere wertvolle Einblicke in das Nutzerverhalten.

- Vereinfachte Beobachtbarkeit von Daten: Log-Management ermöglicht es, Daten aus unterschiedlichen Anwendungen zu sammeln und an einem Ort zu speichern. Dies vereinfacht den Prozess, um wertvolle Daten zur Applikationsperformance, Business-Analytics sowie entscheidende Erkenntnisse für das Troubleshooting zu gewinnen.

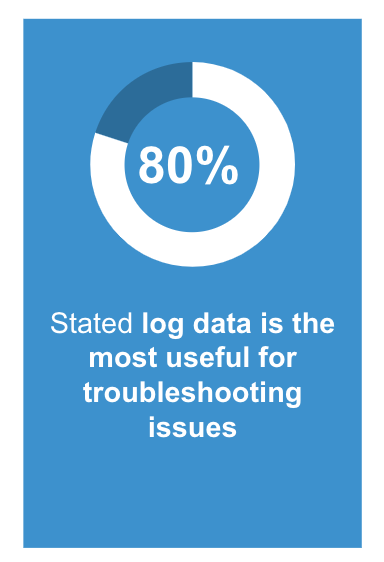

Umfrage unter Sumo Logic-Kunden im Februar 2023 über die nützlichste Art von Daten für die Fehlerbehebung.

Welche Schritte umfasst der Log-Management-Prozess?

„Auch wenn die Details von Unternehmen zu Unternehmen variieren, umfasst jeder Log-Management-Prozess fünf grundlegende Schritte.

1. Instrumentieren und sammeln

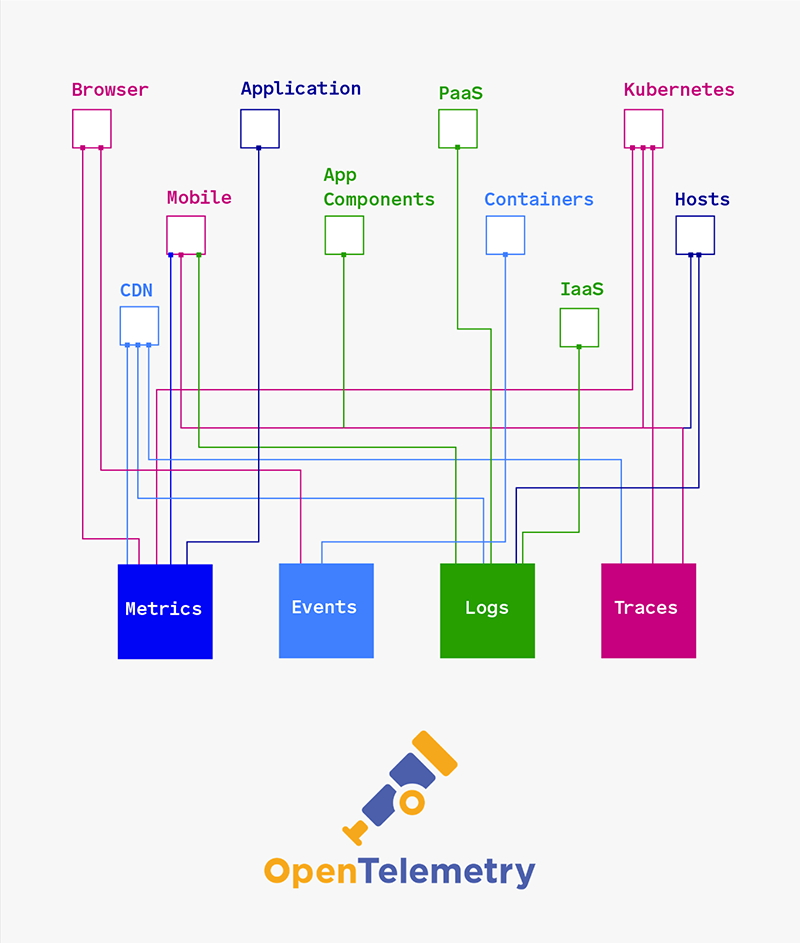

m ersten Schritt des Log-Management-Prozesses erfolgt die Sammlung von Daten aus verschiedenen Quellen Ihres gesamten Tech-Stacks, um die anschließende Log-Aggregation im zweiten Schritt zu ermöglichen. Dieser Vorgang wird mit einem Protokollsammler-Tool durchgeführt. Viele Unternehmen nutzen herkömmliche Tools wie rsync oder cron, die jedoch kein Echtzeit-Monitoring unterstützen. Dabei ist die vollständige Erfassung aller Logs entscheidend für kontinuierliche Monitoring- und Review-Prozesse. Erwähnenswert sind hierbei auch OpenTelemetry-Tools für die Open-Source-Datensammlung: Sie können sämtliche Maschinendaten generieren, erfassen und exportieren. Dies sorgt für eine deutlich höhere Transparenz über alle Ebenen Ihres Tech-Stacks hinweg und ermöglicht eine umfassende Observability.

OpenTelemetry ist eine Sammlung von Tools, APIs und SDKs, mit denen Sie alle Maschinendaten instrumentieren, erzeugen, sammeln und exportieren können.

Es entwickelt sich zum Goldstandard für die Erfassung von Maschinendaten.

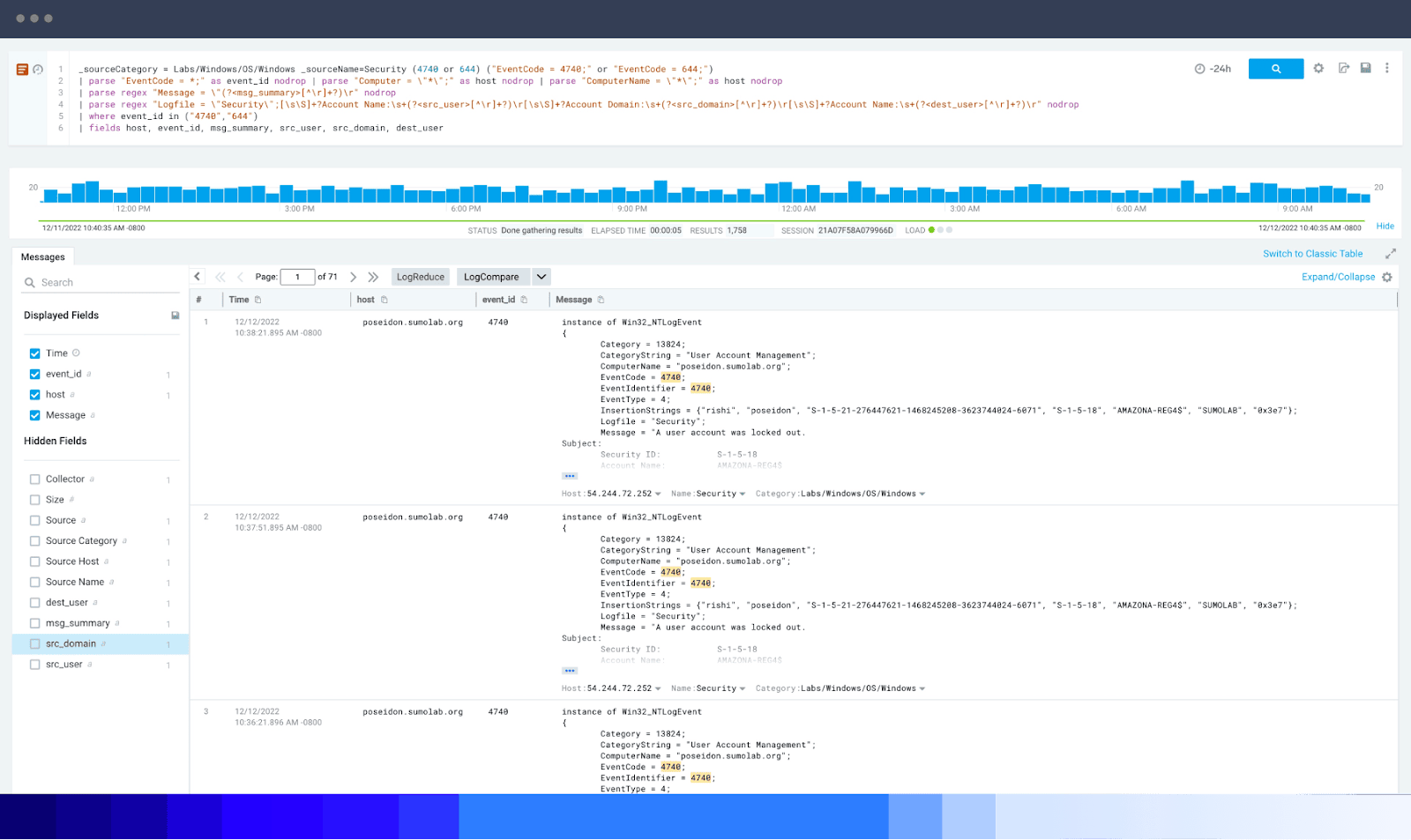

Zusätzlich zur Sammlung ist das Parsing eine weitere wichtige Komponente dieses ersten Schritts. Beim Log-Parsing werden Log-Templates und Parameter extrahiert, um die Logdateien interpretierbar zu machen. Dies ermöglicht es dem Log-Management-System, die in jeder Datei enthaltenen Daten zu lesen, zu katalogisieren und zu speichern. Log-Parsing wird sowohl bei semi-strukturierten als auch bei unstrukturierten Anwendungsfällen eingesetzt, wobei unstrukturierte Daten einen deutlich höheren Aufwand erfordern. Kurz gesagt: Der Parsing-Prozess nimmt schwer verdauliche Daten und wandelt sie in ein besser lesbares Format um.

Das Parsing kann sich bei der Verwendung herkömmlicher Tools als schwierig erweisen. Da Logdaten in vielen verschiedenen Formaten vorliegen, stoßen die Parsing-Funktionen traditioneller Werkzeuge oft an ihre Grenzen. Das bedeutet, dass Benutzer häufig gezwungen sind, eigene Parser zu erstellen – ein enormer Zeitfresser. Um dieses Problem zu lösen, extrahiert Sumo Logic automatisch Felder aus Log-Nachrichten, unabhängig vom Format. Wenn Sie mehr darüber erfahren möchten, werfen Sie einen Blick auf unsere Ressourcen zu Parse-Operatoren.

2. Zentralisieren und indizieren

Sobald alle Logdateien und Daten gesammelt und geparst wurden, folgt als nächster Schritt die Aggregation. Die Log-Aggregation beinhaltet die Konsolidierung aller Logs an einem zentralen Ort auf einer gemeinsamen Plattform, um eine „Single Source of Truth“ zu schaffen. Während die Aggregation für die Zusammenführung sorgt, ermöglicht das Indexing die Durchsuchbarkeit der Daten. So können IT- und Security-Teams die benötigten Informationen effizient abrufen.

Wenn wertvolle Daten in Ihrer IT-Infrastruktur verstreut sind, führt dies zu enormer Ineffizienz und erhöht das Risiko eines Sicherheitsverstoßes. Die mehrfache Erfassung derselben Logdaten für verschiedene Anwendungsfälle erhöht die Kosten für die Beschaffung dieser Daten.

Um die Bedeutung der Aggregation zu verdeutlichen, lohnt ein Blick auf das Log-Management in der Cybersicherheit. Security-Analysten sind oft auf Log-Event-Daten angewiesen, um die Ursache und Schwere einer Sicherheitsverletzung zu bestimmen. Wenn Logdaten über verschiedene Standorte verteilt sind, erschwert dies die Suche nach genau den Informationen, die zur Beseitigung der Cyber-Bedrohung notwendig sind.Die Zentralisierung und Indexierung dieser Informationen bietet eine konsolidierte Ansicht aller Aktivitäten im gesamten Netzwerk. Dies erleichtert es, Bedrohungen zu identifizieren und andere Probleme sofort zu beheben. Eine solche konsolidierte Sicht auf die Logdaten sollte für die meisten Unternehmen oberste Priorität haben, da die rasante Zunahme von Remote-Work völlig neue Herausforderungen für die Cyber- und Datensicherheit mit sich gebracht hat.

Speichern Sie alle strukturierten und unstrukturierten Protokolle und Sicherheitsereignisse in einem einzigen Security Data Lake für maximale Effizienz.

In der Vergangenheit haben sich viele Unternehmen ausschließlich auf Syslog-Shipper verlassen, um Logdaten an einen zentralen Ort zu übertragen. Obwohl diese einfache Methode funktioniert, ist Syslog oft nur schwer skalierbar. Die Cloud-native Plattform von Sumo Logic sowie über 300 Applikationen und Integrationen beseitigen die Ineffizienzen veralteter Produkte wie Syslog-Shipper und vereinfachen den Aggregationsprozess über Ihren gesamten Tech-Stack hinweg.

3. Suchen/abfragen und analysieren

Nachdem die Aggregation abgeschlossen ist, ist es an der Zeit, die Logdaten zu analysieren. Einfach ausgedrückt ist die Log-Analyse die Praxis der Überprüfung und des Verständnisses von Logdaten. Das ultimative Ziel der Log-Analyse ist es, Unternehmen dabei zu helfen, nützliche Analysen und Erkenntnisse aus ihren zentralisierten Protokollen zu gewinnen. Wie alle Log-Management-Verfahren ist auch die Log-Analyse komplex und besteht aus vielen Schichten.

In den folgenden Abschnitten werden wir einige der wichtigsten allgemeinen Fragen rund um die Log-Analyse untersuchen.

Wie funktioniert die Log-Analyse?

Mehrere Methoden und Funktionen ermöglichen es Ihnen, bei der Analyse wertvolle Analysen aus den Protokolldateien zu ziehen:

- Normalisierung ist eine Datenverwaltungsmethode zur Verbesserung der Datenintegrität durch Konvertierung von Daten in ein Standardformat.

- Die Mustererkennung stützt sich auf Machine Learning und Log-Analyse-Software, um festzustellen, welche Protokollmeldungen relevant und welche irrelevant sind. Ohne eine Methode zur Bestimmung des Werts dieser Daten sind Protokolle weniger eine Informations-Goldgrube als vielmehr ein schwarzes Loch.

- Klassifizierung und Tagging helfen Ihnen bei der Visualisierung von Daten. Diese Funktion gruppiert Protokolleinträge in verschiedene Klassen, so dass alle ähnlichen Einträge zusammengehören. Klassifizierung und Tagging erleichtern Ihnen das effiziente Durchsuchen von Logdaten erheblich.

- Die Korrelationsanalyse kommt ins Spiel, wenn Sie ein bestimmtes Ereignis, ob gut oder schlecht, untersuchen. Bei diesem Prozess werden Logdaten von allen Systemen gesammelt, um Korrelationen zwischen den Logdaten und dem zu untersuchenden Ereignis zu ermitteln und auszuwerten.

Tiefgreifende Abfragen durch robuste Protokollabfragen aller Datensätze beschleunigen die Erkennung von Bedrohungen und die Behebung von Leistungsproblemen.

Was sind die Herausforderungen der Log-Analyse?

Protokolle sind die umfassendsten aller Arten von Big Data. Aufgrund ihrer großen Detailfülle sind sie ideale Informationsquellen für die Analyse des Zustands eines jeden Geschäftssystems. Der große Umfang und die Komplexität der Logdaten machen ihre Analyse jedoch aus mehreren Gründen schwierig:

- Logdaten gibt es in vielen Varianten, sie sind meist unstrukturiert und werden in großen Mengen erzeugt, was ihre Analyse für relationale Datenbanken schwierig macht.

- Inkonsistente Protokollformatierung ist ein weit verbreitetes Problem. Da alle Anwendungen und Geräte die Protokollierung unterschiedlich handhaben, ist eine Standardisierung sehr aufwändig.

- Viele Teams brauchen Hilfe bei der richtigen Dimensionierung ihres Protokollspeichers. Protokolldateien können schnell unübersichtlich werden, was die Kosten für Cloud-Speicher in die Höhe treibt.

Tools für große Datensätze meistern diese Herausforderungen. Nehmen wir zum Beispiel Sumo Logic: Die benutzerfreundliche, automatisierte Plattform bietet Echtzeit-Analysen, mit denen Sie Logdaten und vieles mehr in kürzester Zeit auswerten können. Zeitaufwendige und komplexe Installationen oder Upgrades gehören damit ebenso der Vergangenheit an wie die mühsame Verwaltung und Skalierung von Hardware oder Speicherplatz.

Wie kann eine Log-Analyse-Praxis verbessert werden?

Die Vorteile der Log-Analyse sind beeindruckend. Aber wenn Sie die oben genannten Herausforderungen nicht entschärfen, haben Sie nur einen Haufen nicht verwertbarer Daten. Optimieren Sie Ihre Logdaten , um einen echten Nutzen aus Ihren Log-Management-Prozessen und der Logdatei-Analyse zu ziehen.

Log-Analyser und andere Log-Management-Tools optimieren diese Prozesse und gewinnen aussagekräftige Erkenntnisse aus Ihren Logdaten. Der Einsatz dieser Werkzeuge ermöglicht es Entwicklern sowie Security- und Operations-Teams, alle Geschäftsanwendungen nahtlos zu überwachen und Logdaten zu visualisieren, um einen umfassenderen Kontext zu erhalten.

4. Überwachen und alarmieren

Nach der Analyse folgt die Phase des Monitorings und der Alarmierung. Doch was ist eigentlich das Ziel von Log-Monitoring? Die Überwachung von Logdaten sorgt für eine kontinuierliche Lageerkennung. Die vielseitigen Informationen aus Logdateien unterstützen zahlreiche Prozesse, darunter insbesondere das Monitoring der Systemperformance. Sobald die Daten den Analyseprozess durchlaufen haben und IT-Teams erkennen, wo Ineffizienzen und Fehler gehäuft auftreten, können sie Alarme einrichten, um die zuständigen Stellen über die richtigen Kanäle zu benachrichtigen. Log-Monitoring-Verfahren bewerten den Zustand Ihrer Systeme, identifizieren potenzielle Risiken und verhindern Sicherheitsverletzungen.

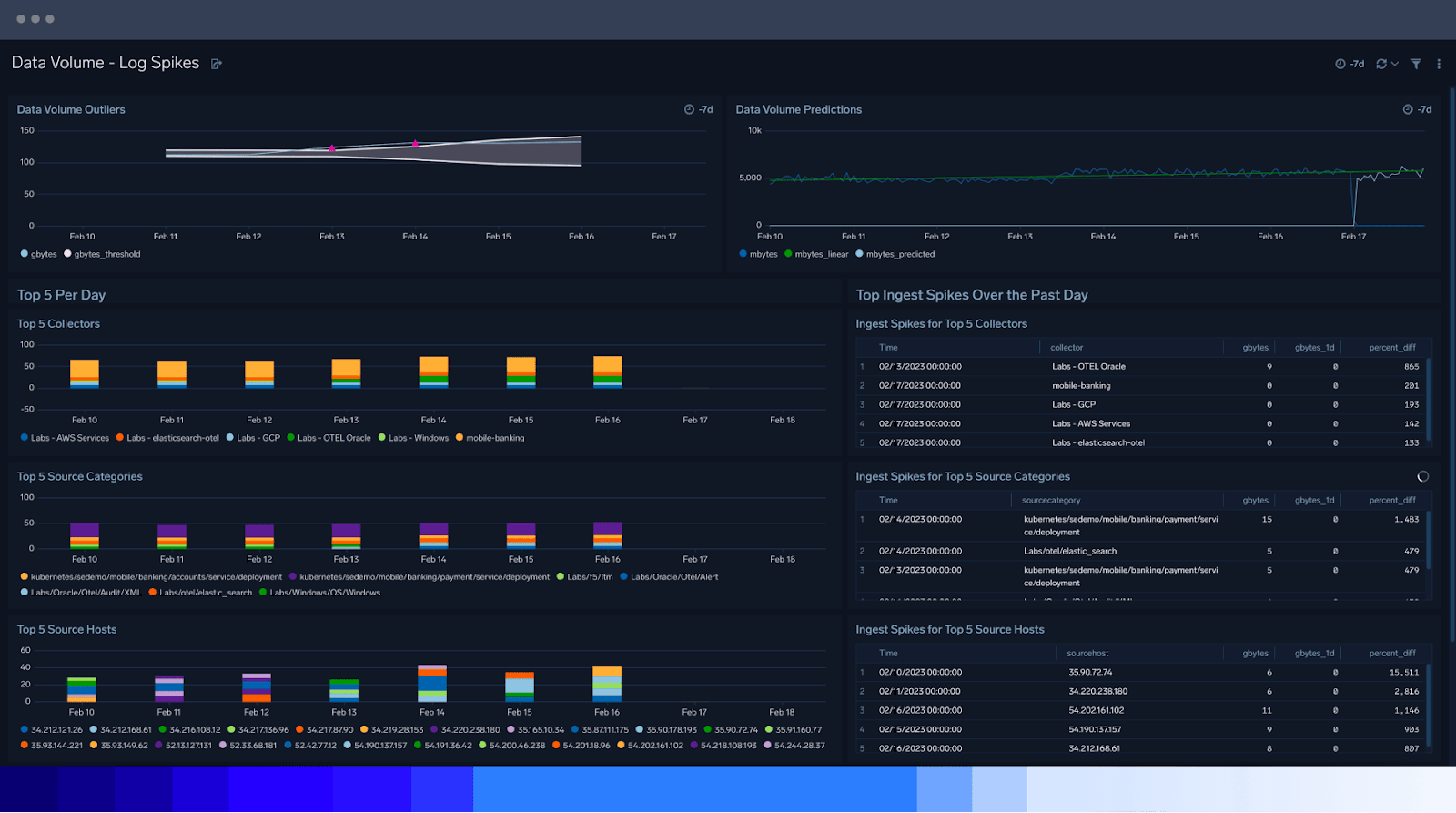

5. Berichterstattung und Dashboarding

Nach dem Sammeln, Analysieren und Überwachen ist es an der Zeit, über Ihre Fortschritte und Erkenntnisse zu berichten. Dazu gehört die Visualisierung wichtiger Daten und Metriken, die im Laufe des Log-Management-Prozesses zutage treten. Mit der Berichterstattung und dem Dashboarding werden zwei Ziele verfolgt:

- Auch wenn Sie mit Standard-Dashboards schnell loslegen können, verwenden Sie benutzerdefinierte Dashboards, um spezifische Analysen auf der Grundlage von Anwendungsfällen zu erhalten.

- Bieten Sie sicheren Zugriff auf vertrauliche Sicherheitsprotokolle und andere sensible Informationen.

- Damit alle Entscheidungsträger und Stakeholder die im Log-Management-Prozess gewonnenen Erkenntnisse nachvollziehen können, müssen diese klar kommuniziert werden.

Was ist eine Log-Management-Richtlinie?

Eine Log-Management-Richtlinie definiert Leitlinien und Prozesse für das Generieren, Sammeln, Speichern, Analysieren und Berichten von Logdaten. Diese Richtlinie sollte umfassend sein, die gesamte IT-Umgebung eines Unternehmens abdecken und alle Personen anweisen, die mit Logdaten interagieren.

Um eine erfolgreiche Log-Management-Richtlinie zu erstellen, sollten Unternehmen:

- die Dinge relativ einfach und skalierbar halten. Anforderungen, die zu unhandlich oder starr sind, werden leicht übersehen.

- ihre Log-Level-Nutzung und ihre Speicherbeschränkungen genau kennen, um eine fundierte Planung zu ermöglichen.

- alle Vorschriften prüfen und Richtlinien entwickeln, die die Compliance fördern. Dies hilft Ihnen auch bei der Entscheidung, wer auf welche Daten zugreifen darf, um angemessene RBAC-Parameter festzulegen.

Beispiel für eine Protokollierungsrichtlinie: Protokollierungs- und Überwachungsrichtlinie NIST 800-53

NIST 800-53 ist ein nordamerikanischer Cybersicherheitsstandard und ein Compliance-Framework, das vom National Institute of Standards in Technology entwickelt wurde. Obwohl nur Bundesbehörden zur Einhaltung der NIST 800-53-Vorschriften verpflichtet sind, kann jedes Unternehmen ähnliche Richtlinien übernehmen.

In NIST 800-53 werden die Anforderungen und Vorschriften für die Protokollierung in der Special Publication (SP) 800-82 dargelegt. Der Log-Management-Standard SP 800-82 bietet praktische, realitätsnahe Anleitungen für die Entwicklung, Implementierung und Wartung effektiver Log-Management-Praktiken im gesamten Unternehmen. Leitlinien für die folgenden Konzepte ziehen sich durch die gesamte Publikation:

- Log-Management-Infrastruktur

- Log-Management-Planung

- Operative Log-Management-Prozesse

Natürlich ist SP 800-82 nicht die einzige Log-Management-Richtlinie auf dem Markt. Viele Länder haben eigene Methoden zur Regulierung von Log-Management-Prozessen entwickelt. Zum Beispiel sind im Vereinigten Königreich sowohl das Justizministerium als auch das National Cyber Security Centre an der Gestaltung der Log-Management-Richtlinien beteiligt.

Was sind Log-Management-Tools?

Da Unternehmen immer komplexere Tech-Stacks und einen erheblichen Anstieg der Logdaten bewältigen müssen, benötigen sie ein System zur Verarbeitung und Verwaltung all dieser Informationen. Auf einer übergeordneten Ebene bieten Log-Management-Tools umfassende und verwertbare Einblicke in den Gesamtzustand und die betriebliche Leistung von Systemen. Sie automatisieren die Prozesse des Log-Managements, um die Compliance zu gewährleisten und gleichzeitig betriebliche, sicherheitsrelevante und geschäftliche Erkenntnisse zu generieren. In letzter Zeit gab es verstärkte Bemühungen, Log-Management-Systeme benutzerfreundlicher zu gestalten, damit auch Nicht-IT-Teams sie problemlos nutzen können. Dies fördert die Zusammenarbeit und Kommunikation im gesamten Unternehmen.

Auf einer Mikroebene umfassen die wichtigsten Funktionen von Log-Management-Tools:

- Fähigkeiten zur Datenbereinigung

- Aggregierte Protokollierung

- Automatisierte Protokollsuche und -überwachung

- Abfragesprachbasierte Suche

- Protokollarchivierung und -indizierung

- Automatisiertes Parsing

- Trend- und zählbasierte Alarmierung

Viele Unternehmen benötigen Log-Management- und Analysesysteme, die über die Grundlagen hinausgehen. Sumo Logic geht mit diesen und anderen Funktionen noch einen Schritt weiter:

- Echtzeit-Analysen

- Lösung aus einer Hand, die Datensilos beseitigt

- Integrierte Observability und Sicherheit

- Hochgradig skalierbare Log-Analyse

- Cloud-native, verteilte Architektur

- Flexible, kostengünstige Lizenzierung

- Unternehmenstaugliche und sichere Multi-Tenant-Architektur

- Sofort skalierbare Analytik

- Standard OOTB und anpassbare Dashboards

- Integrierte Full-Stack-Funktionen

Entdecken Sie mehr Best Practices für das Log-Management

Letztendlich führt ein umfassender und effektiver Log-Management-Prozess zu mehr Sicherheit, besseren Einblicken in alle Geschäftsprozesse und zufriedeneren Kunden. Wenn Sie mehr über Log-Management und -Analyse erfahren möchten, erkunden Sie unser Ressourcen-Repository, lesen Sie unsere Fallstudien oder starten Sie eine kostenlose Testversion, um herauszufinden, ob Sumo Logic die richtige Lösung für Ihr Unternehmen ist.