Kubernetes ist eine erstklassige Lösung für die Container-Orchestrierung, während Docker die am weitesten verbreitete Containerisierungs-Plattform ist. Obwohl sie oft als alternative Lösungen verglichen werden, sind sie keine direkten Konkurrenten. Docker ist eine Container-Technologieplattform und Kubernetes ist ein Container-Orchestrator für Plattformen wie Docker. Tatsächlich ist Kubernetes oft auf Container-Runtimes wie Docker angewiesen, um zu funktionieren, was sie zu komplementären Technologien macht.

Was ist also der Unterschied zwischen Docker und Kubernetes? Wir erläutern die Beziehung zwischen Kubernetes und Docker, räumen mit gängigen Missverständnissen auf und erklären, was Leute wirklich meinen, wenn sie Docker und Kubernetes vergleichen.

Kubernetes vs. Docker: Containerisierung verstehen

Man kann nicht über Docker sprechen, ohne sich vorher mit Containern zu beschäftigen.

Container lösen ein kritisches Problem in der Anwendungsentwicklung. Wenn Entwickler Code schreiben, arbeiten sie in ihrer eigenen lokalen Entwicklungsumgebung. Doch wenn sie diesen Code in die Produktion übertragen, treten Probleme auf. Der Code, der auf ihrem Rechner perfekt funktionierte, läuft in der Produktion nicht – aufgrund unterschiedlicher Betriebssysteme, Abhängigkeiten und Bibliotheken.

Mehrere Container lösten das kritische Problem der Portabilität, indem sie es ermöglichen, den Code von der zugrunde liegenden Infrastruktur zu trennen, auf der er ausgeführt wird. Entwickler konnten ihre Anwendung – einschließlich aller Binärdateien und Bibliotheken, die für einen korrekten Betrieb erforderlich sind – in ein kleines Container-Image packen. In der Produktion kann dieser Container dann auf jedem Computer ausgeführt werden, der über eine Containerisierungsplattform verfügt.

Warum sollte man Container anstelle von virtuellen Maschinen verwenden?

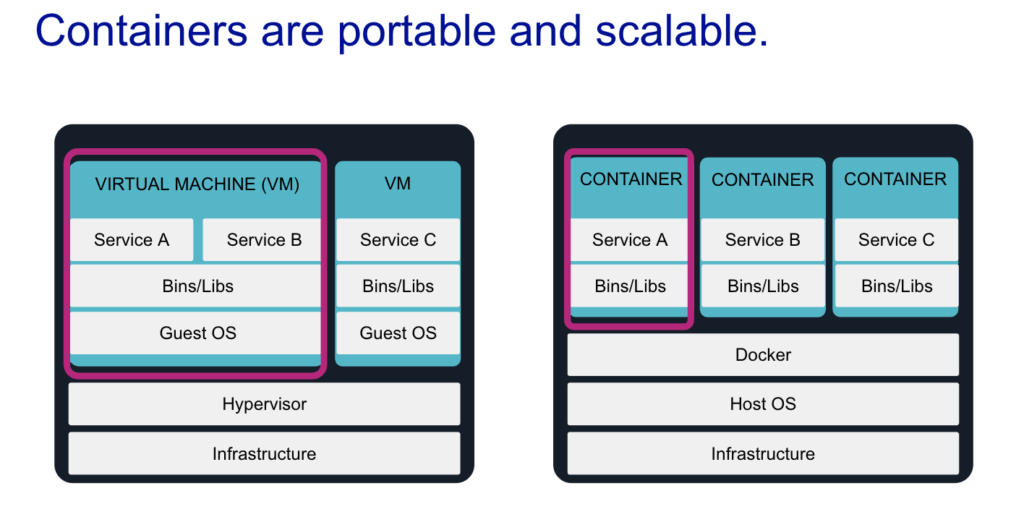

Die Verwaltung von Containern und Container-Plattformen bietet viele Vorteile gegenüber der klassischen Virtualisierung.

Container haben einen extrem geringen Platzbedarf. Sie benötigen lediglich ihre Anwendung sowie eine Definition aller Binärdateien und Bibliotheken, die für den Betrieb erforderlich sind. Im Gegensatz zu virtuellen Maschinen (VMs), die jeweils eine vollständige Kopie eines Gast-Betriebssystems enthalten, erfolgt die Isolation von Containern auf Kernel-Ebene, ohne dass ein Gast-Betriebssystem benötigt wird.

Da Schichten von Container-Images zwischengespeichert und wiederverwendet werden, können ähnliche Container die Duplizierung derselben Abhängigkeiten auf der Festplatte vermeiden. Dies reduziert das Aufblähen von Images und spart zusätzlich Speicherplatz. Wenn Sie beispielsweise drei Anwendungen haben, die alle auf Node und Express basieren, benötigen Sie keine drei separaten Instanzen dieser Frameworks. Die Container können diese Binärdateien und Bibliotheken instanzübergreifend gemeinsam nutzen.

Die Kapselung von Anwendungen in eigenständigen Umgebungen ermöglicht eine schnellere Bereitstellung, eine engere Parität zwischen Entwicklungsumgebungen und eine unbegrenzte Skalierbarkeit.

Was ist Docker?

Docker ist derzeit die beliebteste Containertechnologie und wird von Site Reliability Engineers (SREs), DevOps– und DevSecOps-Teams, Entwicklern, Testern und Systemadministratoren verwendet.

Docker kam zum richtigen Zeitpunkt auf den Markt und war von Anfang an Open Source, was wahrscheinlich zu seiner derzeitigen Marktbeherrschung geführt hat. Laut dem Flexera-Bericht State of the Cloud 2023 verwenden derzeit 39 % der Unternehmen Docker in ihrer AWS-Umgebung, und diese Zahl wächst weiter.

Wichtige Docker-Funktionen

Wenn die meisten Menschen über Docker sprechen, meinen sie die Docker Engine, die Laufzeitumgebung, mit der Sie Container erstellen und ausführen können. Aber bevor Sie einen Docker-Container ausführen können, muss er erstellt werden, beginnend mit einem Dockerfile.

- Dockerfile: Definiert alles, was zum Erstellen eines Container-Images benötigt wird, einschließlich des Basis-Betriebssystems, installierter Pakete, Dateipfade und freigegebener Ports.

- Docker Image: Ein portabler, statischer Blueprint, mit dem laufende Container erstellt werden können. Sobald Sie ein Dockerfile haben, können Sie mit der Erstellung eines Docker-Images beginnen, das auf der Docker Engine ausgeführt wird.

- Docker Hub: Ein öffentliches Registry zum Teilen und Wiederverwenden von Images.

Was ist Kubernetes?

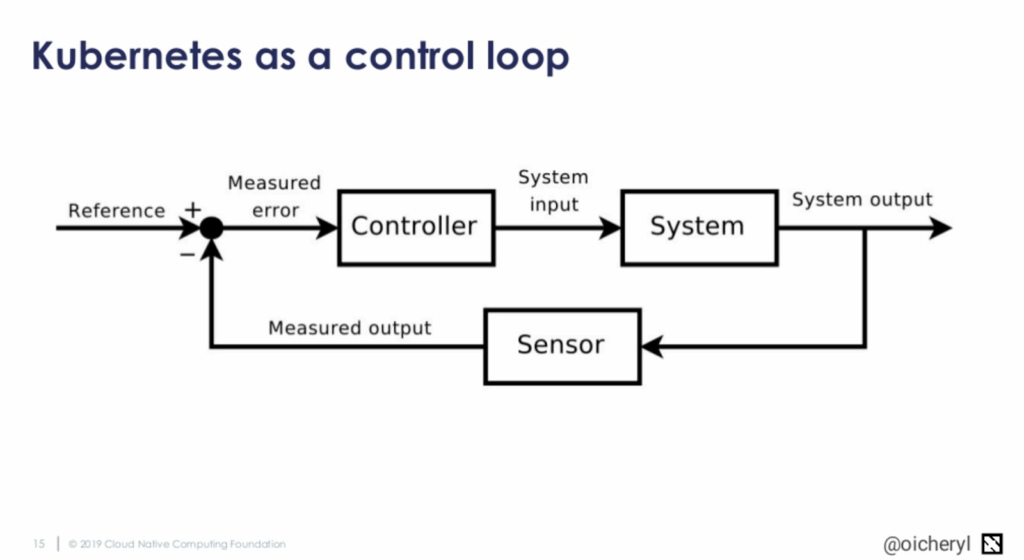

Es ist leicht, sich in den technischen Details von Kubernetes zu verlieren, aber letztendlich ist das Grundprinzip recht einfach. Kubernetes ist eine leistungsstarke Plattform zur Container-Orchestrierung, die ursprünglich von Google entwickelt wurde und heute von der Cloud Native Computing Foundation (CNCF) gepflegt wird. Sie automatisiert die Bereitstellung, Skalierung und Verwaltung von containerisierten Anwendungen über ganze Maschinen-Cluster hinweg.

Sie können beispielsweise entscheiden, wie Ihr System aussehen soll (drei Kopien von Container-Image A und zwei Kopien von Container-Image B), und Kubernetes setzt dies um. Kubernetes vergleicht den gewünschten Zustand mit dem tatsächlichen Zustand, und wenn diese nicht übereinstimmen, unternimmt es Schritte, um sie zu korrigieren.

Kubernetes ist der Marktführer und das standardisierte Mittel zur Orchestrierung von Containern und zur Bereitstellung verteilter Anwendungen. Es kann in einem öffentlichen Cloud-Dienst oder lokal ausgeführt werden, ist hochgradig modular, Open Source und verfügt über eine lebendige Community. Unternehmen aller Größen investieren darin, und viele Cloud-Computing-Anbieter bieten Kubernetes als Service an. Sumo Logic bietet Unterstützung für alle Orchestrierungstechnologien, einschließlich Anwendungen, die auf Kubernetes basieren.

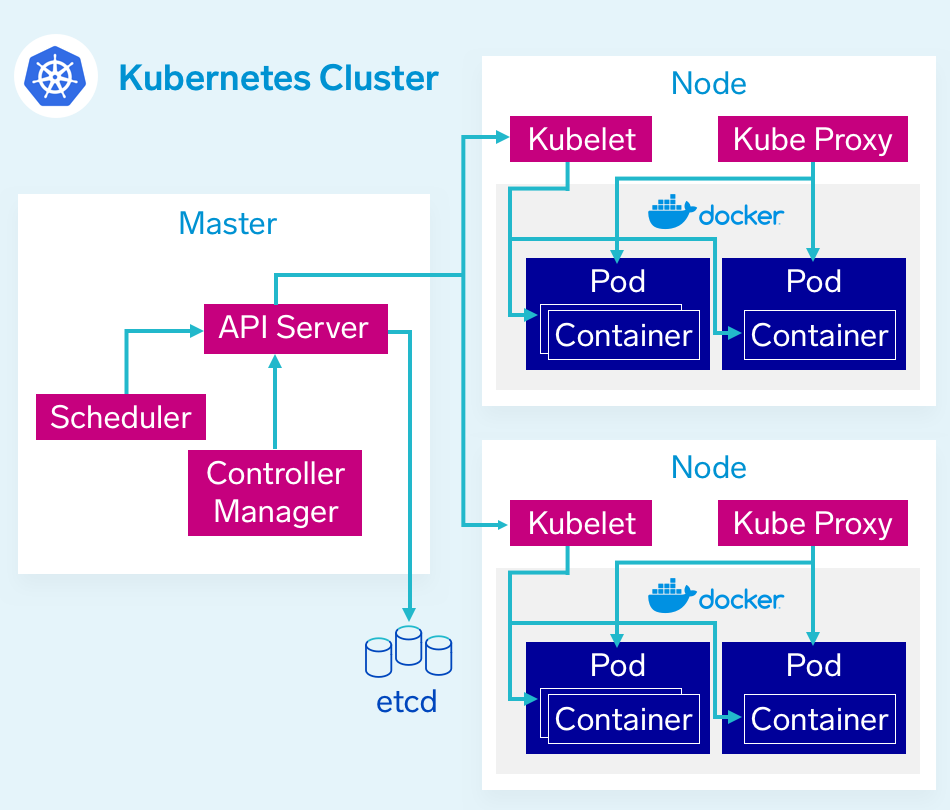

Schlüsselkomponenten der Kubernetes-Architektur

Kubernetes besteht aus vielen einzelnen Komponenten, die nicht direkt voneinander wissen oder sich umeinander kümmern. Stattdessen kommunizieren alle Komponenten über den zentralen API-Server miteinander. Jede Komponente erfüllt eine spezifische Funktion und stellt Metriken bereit, die wir später für das Monitoring erfassen können.

- Steuerebene: Die Steuerebene oder der Master Node orchestriert die Clusteraktivitäten über Komponenten wie den API-Server, den Scheduler und den Controller Manager.

- Nodes: Maschinen (physisch oder virtuell), die Workloads ausführen und die kollektive Rechenleistung des Kubernetes-Clusters bilden. Nodes sind der Ort, an dem Container bereitgestellt werden, um zu laufen, und sie stellen die physische Infrastruktur dar, auf der Ihre Anwendung betrieben wird.

- Pods: die kleinste einsatzfähige Einheit im Kubernetes-Cluster, die oft einen einzelnen Container enthält. Bei der Definition Ihres Clusters werden Grenzwerte für Pods festgelegt, die definieren, welche Ressourcen, CPU und Speicher, sie zum Ausführen benötigen. Der Scheduler verwendet diese Definition, um zu entscheiden, auf welchen Nodes die Pods platziert werden sollen. Wenn ein Pod mehr als einen Container enthält, ist es schwierig, die benötigten Ressourcen abzuschätzen, und der Scheduler kann die Pods nicht angemessen platzieren.

Docker vs. Kubernetes: Brauchen Sie beides?

Während man Docker auch ohne Kubernetes verwenden kann, ist Kubernetes auf eine Container-Runtime angewiesen – etwa Docker, containerd oder CRI-O –, um zu funktionieren. In den meisten Produktionsumgebungen ist Kubernetes + Docker eine gängige Kombination.

Docker ohne Kubernetes ist in der Entwicklung üblich, aber Kubernetes ohne Docker (unter Verwendung einer anderen Container-Laufzeitumgebung) wird in der Produktion immer beliebter.

Docker Compose vs. Kubernetes

Docker Compose und Kubernetes sind beides Frameworks zur Container-Orchestrierung. Der Hauptunterschied zwischen ihnen besteht darin, dass Kubernetes Container auf mehreren virtuellen oder echten Computern ausführen kann, während Docker Compose Container nur auf einer einzigen Host-Maschine betreiben kann.

Kubernetes vs. Docker Swarm

Wenn die meisten Menschen über Kubernetes vs. Docker sprechen, meinen sie eigentlich Kubernetes vs. Docker Swarm. Docker Swarm ist Dockers natives Container-Orchestrierungs-Tool, das den Vorteil hat, eng in das Docker-Ökosystem integriert zu sein und dessen eigene API zu nutzen.

Wie die meisten Scheduler kann Docker Swarm eine große Anzahl von Containern verwalten, die auf Servercluster verteilt sind. Sein Filter- und Planungssystem ermöglicht die Auswahl der optimalen Nodes in einem Cluster für die Bereitstellung von Containern.

Warum Orchestrierungssysteme wichtig sind

Mit der zunehmenden Verbreitung von Docker-Containern hat sich ein neues Problem ergeben:

- Wie kann man mehrere Container koordinieren und planen?

- Wie kann man eine Anwendung nahtlos und ohne Ausfallzeiten aktualisieren?

- Wie überwacht man den Zustand einer Anwendung, wie erkennt man, wenn etwas schief läuft, und wie kann man sie nahtlos neu starten?

Um diese Herausforderungen zu lösen, sind Container-Orchestrierungsplattformen wie Kubernetes, Mesos und Docker Swarm entstanden. Diese Tools sorgen dafür, dass sich ein Cluster von Maschinen wie eine einzige große Maschine verhält, was in einer groß angelegten Umgebung unerlässlich ist.

Die Wahrheit ist, dass Container in einer realen Produktionsumgebung nicht einfach in großem Umfang zu verwalten sind. Container brauchen ein Orchestrierungssystem, damit sie zu Folgendem in der Lage sind:

- Gleichzeitige Verwaltung eines großen Volumens an Containern und Benutzern. Eine Anwendung kann Tausende von Containern und Benutzern haben, die gleichzeitig miteinander interagieren. Die Verwaltung dieser Interaktionen erfordert daher ein umfassendes Gesamtsystem, das speziell für diesen Zweck entwickelt wurde.

- Verwaltung der Suche nach Diensten und der Kommunikation zwischen Containern und Benutzern. Wie kann ein Benutzer einen Container finden und mit ihm in Kontakt bleiben? Jedem Microservice seine eigenen, eingebauten Funktionen für die Dienstsuche zur Verfügung zu stellen, wäre bestenfalls repetitiv und höchst ineffizient. In der Praxis würde dies wahrscheinlich zu unerträglichen Verlangsamungen (oder zum Stillstand) im großen Maßstab führen.

- Lasten effizient ausgleichen. In einer nicht orchestrierten Ad-hoc-Umgebung basieren die Lasten auf Containerebene wahrscheinlich weitgehend auf den aktuellen Benutzeranforderungen, was zu einer stark unausgewogenen Last auf der Serverebene führt. Logjams entstehen durch die ineffiziente Zuweisung und begrenzte Verfügbarkeit von Containern und Systemressourcen. Lastausgleich ersetzt dieses Halbchaos durch Ordnung und effiziente Ressourcenzuweisung.

- Authentifizierung und Sicherheit. Ein Orchestrierungssystem wie Kubernetes erleichtert die Handhabung von Authentifizierung und Sicherheit auf der Infrastrukturebene statt auf Anwendungsebene und ermöglicht die einheitliche Anwendung von Richtlinien über alle Plattformen hinweg.

- Bereitstellung auf mehreren Plattformen. Die Orchestrierung übernimmt die ansonsten sehr komplexe Aufgabe, den Betrieb von Containern, die Verfügbarkeit von Microservices und die Synchronisation in einer Multi-Plattform- und Multi-Cloud-Umgebung zu koordinieren.

Ein Orchestrierungssystem dient als dynamische, umfassende Infrastruktur für eine containerbasierte Anwendung. Es ermöglicht den Betrieb in einer geschützten, hochgradig organisierten Umgebung und verwaltet gleichzeitig die Interaktionen mit der Außenwelt.

Kubernetes ist heute dank seiner modularen Architektur und seiner lebendigen Community die erste Wahl für Container-Orchestrierung.

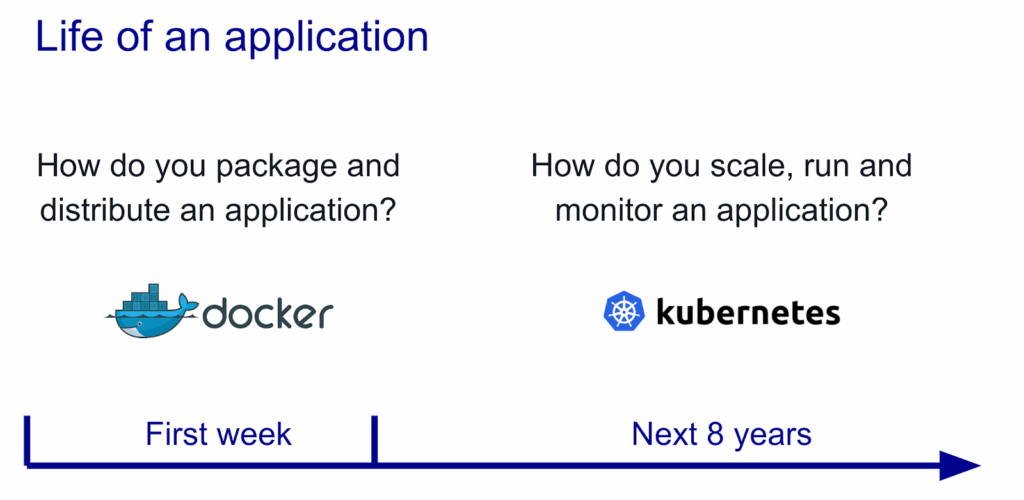

Die Beziehung zwischen Docker und Kubernetes

Kubernetes und Docker sind beides de facto Standardlösungen für die intelligente Verwaltung containerisierter Anwendungen und bieten leistungsstarke Funktionen. Daraus ist eine gewisse Verwirrung entstanden: „Kubernetes“ wird heute manchmal als Synonym für eine gesamte, auf Kubernetes basierende Container-Umgebung verwendet. In Wirklichkeit sind sie jedoch nicht direkt vergleichbar, haben unterschiedliche Wurzeln und lösen unterschiedliche Probleme.

Docker ist eine Plattform und ein Werkzeug zum Erstellen, Verteilen und Ausführen von Docker-Containern. Es umfasst Tools wie Docker Desktop, Docker CLI und Docker Daemon.

Kubernetes hingegen ist ein Container-Orchestrierungssystem für Docker-Container, das umfangreicher ist als Docker Swarm und Cluster von Nodes in großem Maßstab koordiniert. Es arbeitet mit dem Konzept der Pods, die im Kubernetes-Ökosystem Planungseinheiten sind (und einen oder mehrere Container enthalten können). Sie werden auf die Nodes verteilt, um hohe Verfügbarkeit zu gewährleisten. Man kann ein Docker-Build problemlos auf einem Kubernetes-Cluster ausführen, aber Kubernetes selbst ist keine vollständige Lösung und soll benutzerdefinierte Plugins enthalten.

Kubernetes und Docker sind grundlegend unterschiedliche Technologien, die jedoch sehr gut zusammenarbeiten. Beide erleichtern die Verwaltung und Bereitstellung von Containern in einer verteilten Architektur.

Kann man Docker ohne Kubernetes verwenden?

Docker wird in der Regel ohne Kubernetes verwendet. Obwohl Kubernetes viele Vorteile bietet, ist es bekanntermaßen komplex, und es gibt viele Szenarien, in denen der Aufwand, Kubernetes aufzusetzen, unnötig oder unerwünscht ist.

In Entwicklungsumgebungen ist es üblich, Docker ohne einen Container-Orchestrator wie Kubernetes zu verwenden. In Produktionsumgebungen überwiegen die Vorteile eines Container-Orchestrators oft nicht die Kosten der zusätzlichen Komplexität. Darüber hinaus bieten viele öffentliche Cloud-Dienste wie AWS, GCP und Azure eigene Orchestrierungsfunktionen an, wodurch die Inkaufnahme der zusätzlichen Komplexität unnötig wird.

Kann man Kubernetes ohne Docker verwenden?

Da Kubernetes ein Container-Orchestrator ist, benötigt es eine Container-Runtime, um die Orchestrierung durchführen zu können. Kubernetes wird am häufigsten mit Docker verwendet, kann aber auch mit jeder anderen Container-Runtime genutzt werden. RunC, cri-o und containerd sind weitere Container-Runtimes, die Sie mit Kubernetes einsetzen können. Die CNCF führt eine Liste der empfohlenen Container-Runtimes auf ihrer Ecosystem-Landscape-Seite auf, und die Kubernetes-Dokumentation bietet spezifische Anleitungen für die Einrichtung mit ContainerD und CRI-O.

Fazit: Docker und Kubernetes arbeiten am besten zusammen

Was ist also die beste Wahl? Das ist keine Fangfrage. Die Antwort ist offensichtlich: beides.

Obwohl Kubernetes auch andere Container-Quellen und -Laufzeiten verwenden kann, ist es auf die Zusammenarbeit mit Docker ausgelegt, und ein Großteil der Dokumentation wurde mit Blick auf Docker verfasst.

Gemeinsam liefern sie:

- Zuverlässige, wiederholbare Containerbereitstellung

- Zentralisierte Verwaltung von Container-Laufzeitschnittstellen

- Ausfallsichere Infrastruktur mit automatischem Failover

- Unterstützung für Cloud-native Anwendungen im großen Maßstab

Es war nie wirklich eine Frage von Kubernetes vs. Docker; es war schon immer ein Miteinander von Kubernetes und Docker, und heute gilt dies mehr denn je. Für jedes Team, das mit modernen Container-Technologien arbeitet, bietet die Einführung von sowohl Docker als auch Kubernetes die robusteste und skalierbarste Grundlage für die Erstellung und den Betrieb verteilter Anwendungen.

Entdecken Sie, wie Sumo Logic Kubernetes- und Docker-Leistungsdaten in verwertbare Erkenntnisse umwandelt. Registrieren Sie sich für eine kostenlose 30-Tage-Testversion.